「コグニティブコンピューティング」はIBMやマイクロソフトなどIT大手がサービスを提供しているシステムで、実際にさまざまな分野で導入されています。AIとの違いや具体的なサービス・機能などについて解説し、これからの進化の過程についても考えてみましょう。

目次

コグニティブコンピューティングとは

コグニティブコンピューティング(cognitive computing)とは一体どのようなシステムなのでしょうか。

cognitiveとは「認識」「認知」という意味で、入力された命令を処理するだけでなく、自律的に考え、学び、理解・行動するシステムということになります。人間も自ら理解、推論、学習することから、人間に近いシステムといえるでしょう。

人間に近いという意味で、コグニティブコンピューティングは従来のコンピュータでは分析対象にならなかった、画像や音声、自然言語、表情といった非構造化データも対象にします。これが主に数値や単純な文章などの構造化データしか理解ではなかった従来のコンピュータシステムとは異なる点です。

構造化データは、Excelなどのように列と行などで整理されたデータを指します。項目名や内容が構造化されていて検索などがしやすくなっており、適宜並べ替えることも可能です。従来のコンピュータは、こうした構造化データしか取り扱うことができませんでした。

一方、非構造化データは構造が定義されておらず、検索や解析などには不向きなデータです。具体的にはメール、文章、デザイン・Computer Aided Design(CAD)データ、画像、動画、音声などがあります。これらの実例の通り、今後業務などで増加していくのは非構造化データであり、ビジネスに役立つデータという意味でも、非構造化データを扱えるコンピュータはますます重要になってくることは明らかです。

こうした非構造化データを取りこんで、さまざまなサービスを提供するコグニティブコンピューティングでは、複雑で膨大なこれらのデータを自律的に判断・処理します。類似するインプットを与えたとしても、導きだす答えは一定ではありません。複数の選択肢の中から状況に応じて最適な解を提供します。

コグニティブコンピューティングをIT企業の中で率先して研究してきたIBMは、コグニティブコンピューティングについて「人間が話す自然言語を理解し、根拠をもとに仮説を立てて評価して、コンピュータ自身が自己学習を繰り返して知見を蓄える技術を活用した、コンピューティングの新しい概念」と定義付けています。

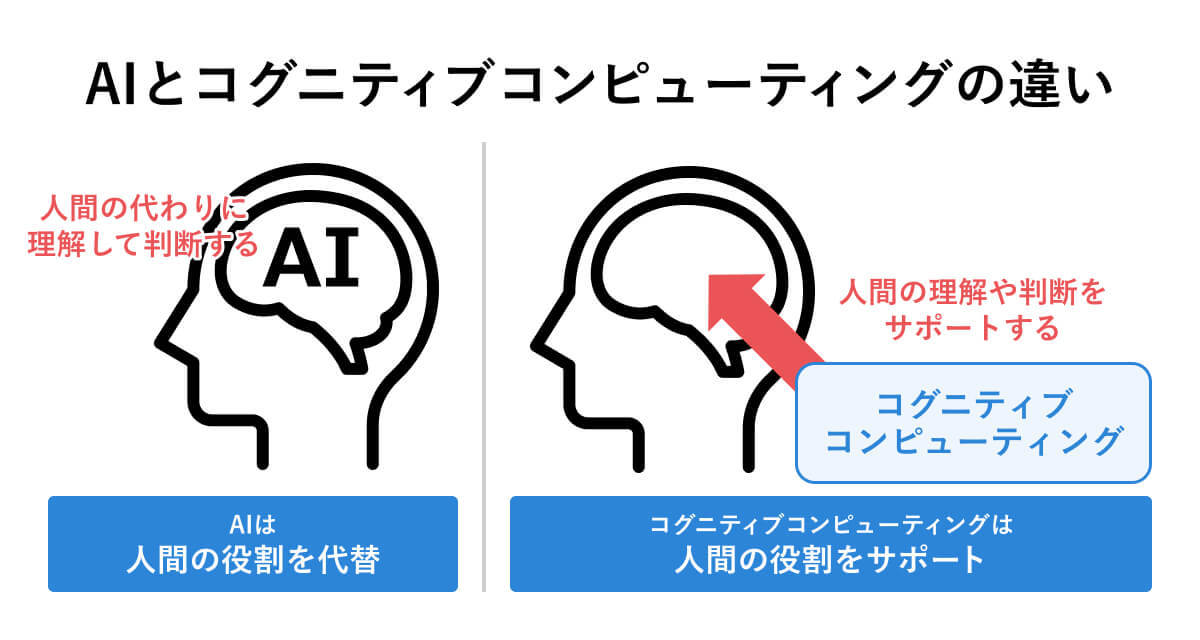

AIとどう違うのか

これまでコグニティブコンピューティングとAIは混同して解釈され、あまり厳密な定義の区別をしないまま使われることも多いようです。

コグニティブコンピューティングの第一人者的存在であるIBMでは、コグニティブコンピューティングとAIは同じものではないが、相反するのではなく、ともに並立して人間社会に貢献するもの、という意味のことを発しています。なお、同社はコグニティブコンピューティングに関するサービスだけでなく、AI関連の製品、サービスも提供しています。

では、コグニティブコンピューティングとAIの最も異なる特徴は何なのでしょうか。そのヒントになるメッセージをIBMは「コグニティブって知ってる?AIとは違うIBMの目指す世界とは」のなかで伝えています。

その中で「コグニティブ・システムは人の意思決定を支援するという明確な目的意識を設計思想の中心にする」とし、「科学技術の発展を目的とするのではなく、『人間を支援する』ことを目的とするのである。ここがAIとの大きな違いだ。」と明言しています。

前述したように、コグニティブコンピューティングは状況に応じて導きだす答えは一定ではなく、複数の選択肢の中から状況に応じて最適な解を提供します。人のおかれた状況に応じて最適な回答を提供し、人間に判断や行動をうながすのです。

例えば、銀行や役所での各種手続きなどの生活シーンで、タブレット端末などの電子機器に自ら入力しなければならないということがあります。しかし高齢者にとっては、うまく操作できないこともあるでしょう。そんなときコグニティブコンピューティングは、利用者の状況に応じて、何が理解できていないか、何をすればいいのかなどを学習したデータから導き出し、問題解決に導きます。

実際に現在利用されているコグニティブコンピューティングの代表的なソリューションは、人間の自然言語を理解してユーザーの疑問や問題を自己解決する自動会話プログラム(チャットボット)などです。

このようにコグニティブコンピューティングは、AIのように人間の行動を肩代わりし、さまざまな判断や決定も行うのではなく、人間が判断するためのサポートに徹する仕組みだといえます。

コグニティブコンピューティングの強み

構造化データと非構造化データの両方を取り扱うコグニティブコンピューティングは、見る、聞く、話す、読む、考えるといった人間の能力をサポートするため、膨大な情報のなかで最適な判断、行動を選択できるように促すことができます。

判断、行動をうながすだけではなく、人間の代わりに機械の操作を命令すれば、その通りに動きます。例えば、前述の銀行や役所での各種手続きなどで困っている高齢者には、どのように操作すればいいのか導くこともしますが、場合によっては、本人に代わってデータを入力することも可能です。

本人が入力する場合、誤った入力をする可能性がありますが、コグニティブコンピューティングであれば、それも防ぐことができます。映像などからヒューマンエラーを発見し、それに注意を促し、場合によってはシステム側で補助する、といったサービスもできるのです。

またコグニティブコンピューティングは、学習を重ねることで回答の正解率を上げていきます。もちろん初期段階はサンプルとなるデータが必要ですが、データが蓄積され学習経験を積むことで、自らエラーを改善していきます。AIの場合は人間が教育用のデータを入力し、学習させる必要がありますが、コグニティブコンピューティングは人間の手を煩わせることはAIよりも少なくて済みます。

どんな活用事例が考えられるのか?

では、産業界においてコグニティブコンピューティングはどのように利用されるのでしょうか。

まず考えられるのは、コールセンターやカスタマーサポートでの顧客対応です。

音声認識機能を使って顧客の話している内容を即座にテキスト化してオペレーターや管理者に伝え、それらのデータを蓄積します。それだけではなく、顧客の声のトーンや話し方によって、相手の心理状態を察し、どんな対応が最適なのかをオペレーターに伝えるといったこともできるでしょう。

さらにチャットボットの自動回答でも、相手が書き込む内容から、最適な言葉遣いや内容を導き出すことも可能です。

コグニティブコンピューティングは自然言語をデータとして取り入れる機能を特に高度化してきた経緯があるため、このような業務ではすでにシステムとして導入されているケースもいくつも見られます。

このほかには、マーケティング分野での分析作業にも利用されつつあります。自社のWebサイトやSNSでの書き込みを大量に収集し、商品やサービスの改善に役立つ仮説を提供することもできます。サイトやSNSでの書き込みは自然言語ですが、コグニティブコンピューティングはこうした情報も大量に処理できるので、人間だけで分析作業をするよりも、迅速かつ正確に行うことができます。

またコグニティブコンピューティングは、ビッグデータと呼ばれる膨大なデータも処理できるので、気象予測や災害対応などの分析作業も得意です。工場内で発生する膨大な機器データから異常発生を事前に察知する、といったこともできるでしょう。

こうした分析や判断は、ベテランの担当者が身に着けている知見が密接に関係しますが、コグニティブコンピューティングはさまざまな事象を学習することで、こうした経験知や技術の継承に貢献できます。

代表的なサービスと活用シーン

コグニティブコンピューティングの代表的なサービスとしてIBMの「Watson」とMicrosoftの「Azure Cognitive Services」あります。

IBM「Watson」

「Watson」は2006年にわれわれが日常使用している言葉、自然言語による質問に迅速・正確に答える「質問応答システム」として開発がスタートしました。

「Watson」が注目を浴びたのは開発から5年後の2011年、米国のクイズ番組「Jeopardy!」に挑戦し、人間のチャンピオンに勝利したことでしょう。「Jeopardy!」は大変レベルの高いクイズ番組で、質問もユーモアや皮肉の混じったものもあり、「Watson」の勝利は大きな反響を呼びました。

「Watson」は現在①チャットボットを開発するためのサービス「Watson Assistant」、②画像認識サービス「Visual Recognition」、③音声認識サービス「Speech to Text」、④性格分析サービス「Personality Insights」⑤テキストデータについての言語分析サービス「Tone Analyzer」の5つのサービスをAPI(Application Programming Interface)で提供しています。

利用者は「Watson」用のソフトウェアを購入する必要はなく、APIという「プラグ」を使う契約をして必要な機能と自社のシステムとをつないで利用することができます。

これらのサービスは、長年の学習経験を蓄積して最適化しているため、例えば音声認識サービスにおいても自社向けに一から学習させる必要はありません。

Microsoft「Azure Cognitive Services」

一方でMicrosoftの「Azure Cognitive Services」は、視覚、音声、Language、決定という4つの主要な柱に分類できるサービスです。このサービスもAPIで提供されています。

①Vision(視覚) APIは、画像を処理して情報を返すための高度なコグニティブ アルゴリズムにアクセスできます。また顔属性の検出と認識を有効にする、高度な顔アルゴリズムへのアクセスも提供しています。

②Speech(音声) APIは、音声対応の機能をアプリケーションに追加し、音声テキスト変換、テキスト読み上げ、音声翻訳などの機能を提供します。

③Language APIは、テキストを理解して分析するための複数の自然言語処理(NLP)機能やほぼリアルタイムでのマシン ベースのテキスト翻訳機能、クラウドベースの会話型 AI サービスなどを提供します。

④Decision(決定) APIは、時系列データを監視し異常を検出したり、特定のコンテンツを監視したりする機能があります。またユーザーのリアルタイムの動作から学習し、ユーザーに最良のエクスペリエンスを選択できるようにします。

このようにコグニティブコンピューティングによるサービスは、特定の用途向けに十分に学習させた機能を、簡単に利用できる汎用性を特質としており、高い専門性を有していなくても使いこなせるものです。このあたりもAIとは異なる性質といえるでしょう。

画像認識技術を活用してハワイのおすすめスポットを提案

それでは「Watson」を活用した企業の事例を見てみましょう。

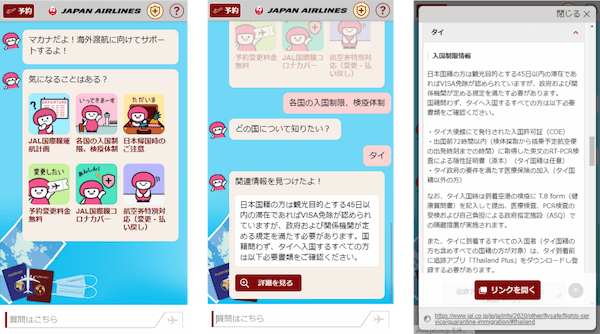

日本航空は、「Watson」を活用してバーチャルアシスタント「マカナちゃん」を開発しました。このサービスは、チャット形式の自然な対話で、ハワイの現地情報やおすすめスポットを回答するもので、ハワイ島のさまざまな施設情報を最新の口コミや画像付きで提示します。

※「マカナちゃん」の展開イメージ(画像出典:日本航空プレスリリース)

日本航空は「マカナちゃん」のサービス向上を続けており、利用者が自身で撮影した写真や、見たい景色、食べたいものなどの画像を「マカナちゃん」に送信することで、画像の分析結果とそれに応じたハワイのおすすめスポットの情報を受け取ることが可能です。例えばゴルフ風景の写真を送信するとハワイにあるゴルフ場の情報が表示されます。

この機能強化は、IBM Watsonの会話(Conversation)機能、性格分析(Personality Insight)機能にプラスして画像認識(Visual Recognition)機能を新たに活用したものです。

また日本航空では、「Watson」の性格分析サービスを利用して、投稿内容から利用者を9タイプに分類するサービスを提供して好評を得ています。

聴覚障害を持つ社員との円滑なコミュニケーション

「Azure Cognitive Services」では、田辺三菱製薬の活用事例があります。

同社では、コロナ禍の下、マスクで口元が見えないなかで、聴覚障害を持つ社員とどのようにスムーズな意思疎通を図るかが課題となっていました。また誰もがストレスなく英語での会議に参加できる環境が必要とされていました。 聴覚障害者は、身ぶり手ぶり、そして口の動きで会話の内容を把握します。しかしマスクの着用や、オンライン会議では、コミュニケーション自体が極めて困難です。会議の内容は文字起こしをして、共有することもできますが、タイムラグが生じ、情報共有に問題が発生していました。

そこで「Azure Cognitive Services」 の Speech Services を活用したフェアユースの「リアルタイム翻訳ツール」を活用することにしました。これは、Microsoft Teams(Teams)と連携して、Teams 会議でやりとりされる音声をリアルタイムに翻訳、テキスト化します。

聴覚障害を持つ社員は、「このツールを導入してからは、会議の音声をリアルタイムに認識して文字にするので、相手の口元が見えていないときでも、PCの画面を見ていれば相手が話している内容を理解できるようになった」と高く評価しています。

コグニティブコンピューティングがこれからめざすもの

IBMは自社の「Watson」を拡張知能と位置付けて、APIの種類を増やしていくとともに、さまざまなITインフラ上で容易に導入しやすくするさまざまな開発を行っています。

一方、近い将来AIが人間の能力を超える「シンギュラリティ(技術的特異点)」を迎えるといわれ、人間の仕事の多くを奪ってくのではないか、という脅威論も根強く残っています。

コグニティブコンピューティングの先駆的企業であるIBMは「ディープランニング(深層学習)エンジンだけのAIではビジネスアプリケーションから求められる機能にしっかり応えることはできない」としています。

しかし「Watson」が最初に注目を浴びた2011年から多くの時間が過ぎ、AIも「Watson」自体も変化し続けています。双方は補完的な関係であることは間違いありません。特にAIはさまざまビジネス活用が進むにつれ、サービス化が進み、「Watson」のような機能提供の仕方をする動きがでているようです。

こうした動きを見ていると、深層学習エンジンとしてのAIが、コグニティブコンピューティングが核としている「人間を支援する」という考え方を「学習」し、次第に境界を溶かそうとしているかのようにも思えてきます。

AIの進化と並行してコグニティブコンピューティングも発展していくことで、より広範な人々を対象に、暮らしを支える重要なサービスが生まれてくるのではないでしょぅか。

【こんな記事も読まれています】

・国内製造業の再生を狙うINDUSTRIAL-Xが推進する[ESG×DX]時代の戦い方

・製造業における購買・調達業務とは?課題の解決方法も紹介

・サプライチェーン排出量はなぜ注目される?算定方法も含めて紹介